Pourquoi l’alignement de l’IA pourrait être difficile avec l’apprentissage profond moderne

Holden a précédemment mentionné l’idée que les systèmes d’IA avancés (par exemple PASTA) pourraient développer des objectifs dangereux qui les amèneraient à tromper les humains ou à les déposséder de leur pouvoir. Cette inquiétude peut sembler bien étrange. Pourquoi programmerions-nous une IA qui nous veut du mal ? Mais je pense qu’il pourrait s’agir d’un problème difficile à éviter, en particulier si l’IA avancée est développée à l’aide de l’apprentissage profond (souvent utilisé pour développer l’IA de pointe aujourd’hui).

Dans l’apprentissage profond, nous ne programmons pas un ordinateur à la main pour qu’il effectue une tâche. En gros, nous recherchons un programme informatique (appelé modèle) qui effectue bien la tâche. En général, nous ne savons pas grand-chose du fonctionnement interne du modèle que nous obtenons, nous savons seulement qu’il semble faire du bon travail. Cela ressemble moins à la construction d’une machine qu’à l’embauche et à la formation d’un employé.

Et tout comme les employés humains peuvent avoir de nombreuses motivations différentes pour faire leur travail (de la croyance en la mission de l’entreprise à l’appréciation du travail quotidien, en passant par la simple recherche d’argent), les modèles d’apprentissage profond peuvent également avoir de nombreuses « motivations » différentes qui conduisent toutes à de bonnes performances dans une tâche. Et comme ils ne sont pas humains, leurs motivations pourraient être très étranges et difficiles à anticiper, comme s’il s’agissait d’employés extraterrestres.

Nous commençons déjà à voir des preuves préliminaires que les modèles poursuivent parfois des objectifs que leurs concepteurs n’avaient pas prévus (ici et ici). Pour l’instant, ce n’est pas dangereux. Mais si cela continue à se produire avec des modèles très puissants, nous pourrions nous retrouver dans une situation où la plupart des décisions importantes – y compris le type de qu’il faut viser – sont prises par des modèles sans tenir compte de ce que les humains valorisent.

Le problème de l’alignement de l’apprentissage profond consiste à s’assurer que les modèles d’apprentissage profond avancés ne poursuivent pas des objectifs dangereux. Dans la suite de ce billet, je vais.. :

Cette section décrit une analogie pour tenter d’illustrer intuitivement pourquoi il est difficile d’éviter un mauvais alignement dans un modèle très puissant. Il ne s’agit pas d’une analogie parfaite, mais d’une tentative de communiquer certaines intuitions.

Imaginez que vous êtes un enfant de huit ans dont les parents vous ont légué une entreprise d’un billion de dollars et qu’aucun adulte de confiance ne peut vous guider dans le monde. Vous devez engager un adulte intelligent pour diriger votre entreprise en tant que PDG, gérer votre vie comme le ferait un parent (par exemple, décider de votre école, de votre lieu de résidence, de l’heure à laquelle vous devez aller chez le dentiste) et administrer votre immense richesse (par exemple, décider où vous allez investir votre argent).

Vous devez embaucher ces adultes sur la base d’un essai de travail ou d’un entretien que vous proposez — vous n’avez pas le droit de voir les CV, de vérifier les références, etc. Parce que vous êtes si riche, des tonnes de gens postulent pour toutes sortes de raisons.

Votre banque de candidats comprend :

Comme vous avez huit ans, vous ne saurez probablement pas concevoir le bon type de tests de travail, de sorte que vous pourriez facilement vous retrouver avec un flagorneur ou un magouilleur :

Quoi que vous puissiez imaginer, il semble que vous puissiez facilement embaucher un flagorneur ou un magouilleur et lui confier tout le contrôle fonctionnel. Si vous n’embauchez pas un Saint – et surtout si vous embauchez un magouilleur – dans les faits, vous cesserez très vite d’être le PDG d’une entreprise géante. Lorsque vous serez adulte et que vous vous rendrez compte de votre erreur, il y a de fortes chances que vous soyez sans le sou et impuissant à inverser la tendance.

Dans cette analogie :

Dans la section suivante, j’entrerai un peu plus dans le détail du fonctionnement de l’apprentissage profond et j’expliquerai pourquoi les flagorneurs et les magouilleurs pourraient apparaître en essayant d’entraîner un puissant modèle d’apprentissage profond tel que PASTA.

Dans cette section, je vais faire le lien entre l’analogie et les processus d’entraînement réels de l’apprentissage profond en :

Ceci est une explication simplifiée qui donne une idée générale de ce qu’est l’apprentissage profond. Voir ce billet pour une explication plus détaillée et plus précise sur le plan technique.

L’apprentissage profond consiste essentiellement à rechercher la meilleure façon d’organiser un modèle de réseau neuronal — qui est comme un « cerveau » numérique avec de nombreux neurones numériques connectés les uns aux autres avec des connexions d’intensité variable — pour lui permettre d’effectuer correctement une certaine tâche. Ce processus, appelé entraînement, implique un grand nombre d’essais et d’erreurs.

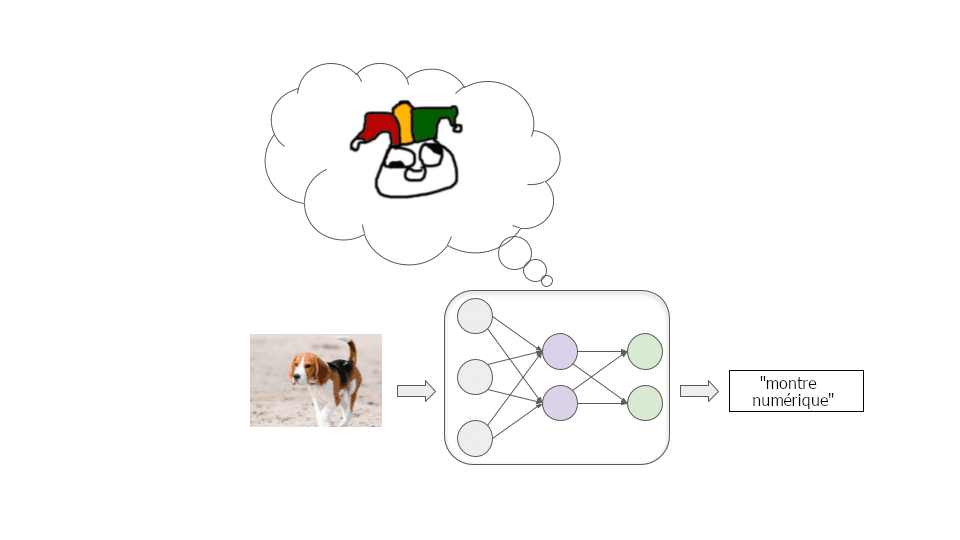

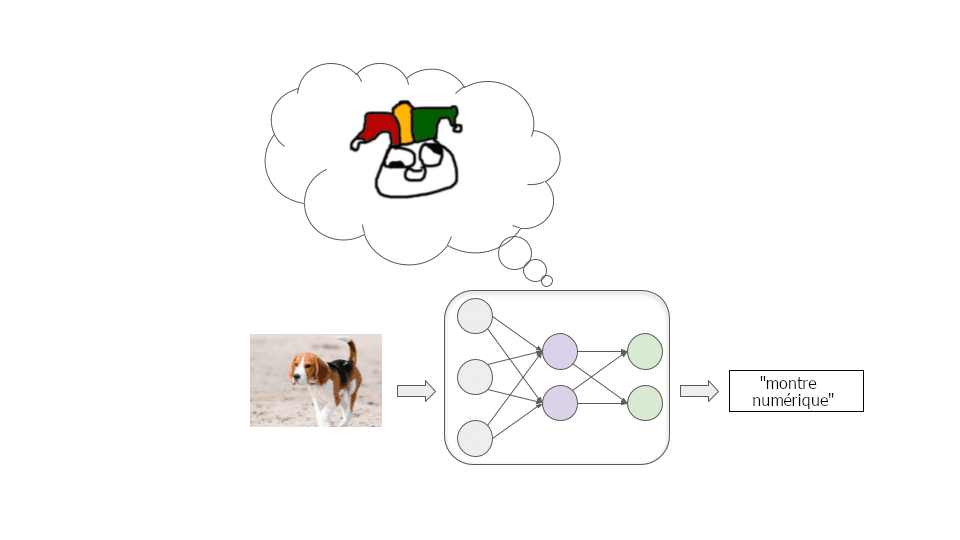

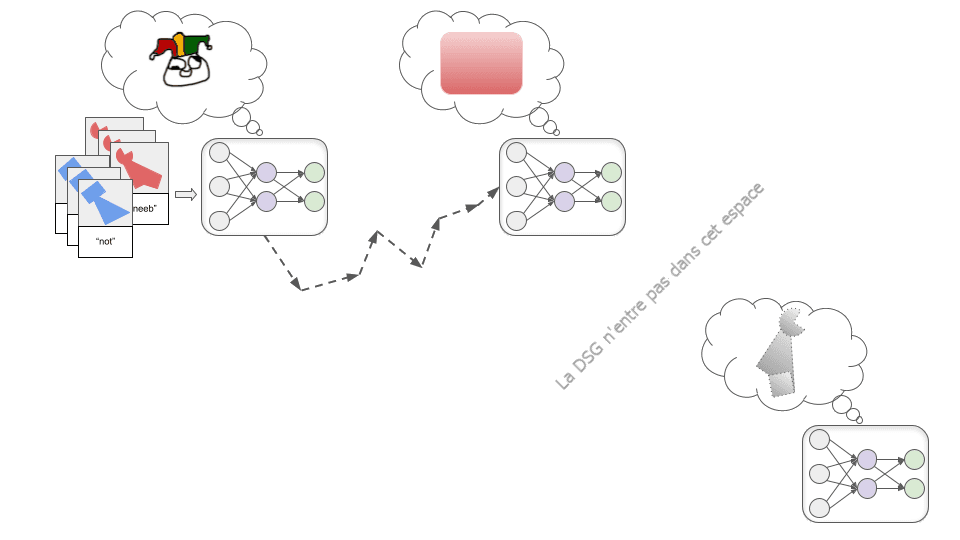

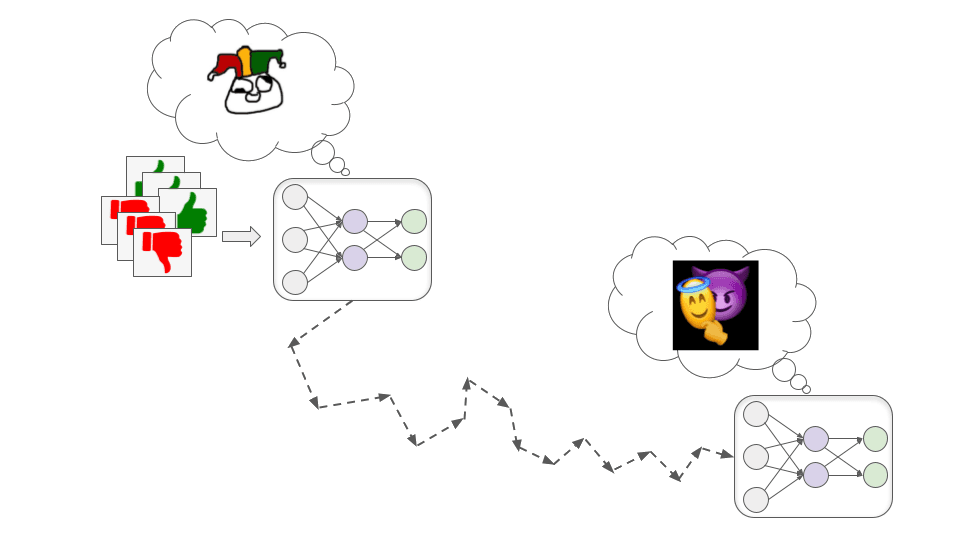

Imaginons que nous essayons d’entraîner un modèle à bien classer des images. Nous commençons par un réseau neuronal dans lequel toutes les connexions entre les neurones ont des forces aléatoires. Ce modèle étiquette les images de manière extrêmement incorrecte :

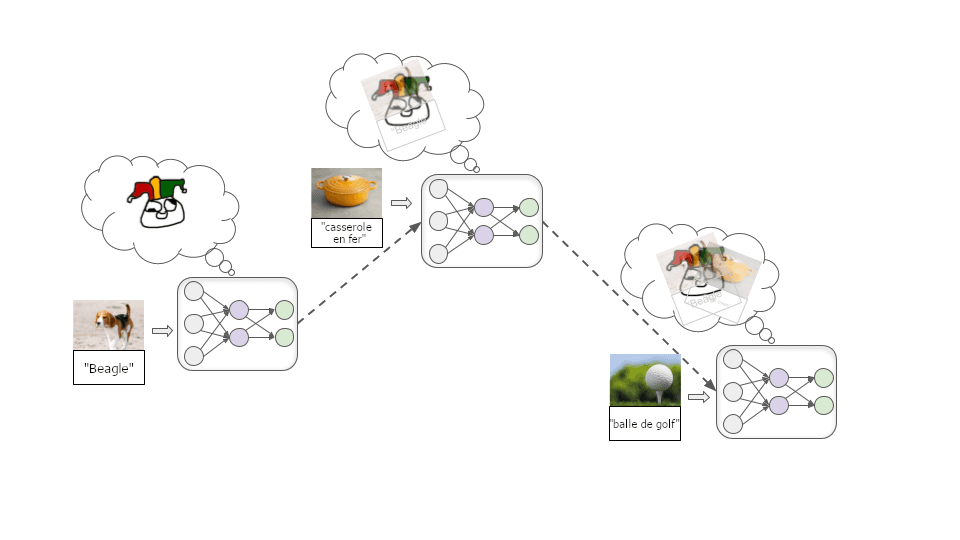

Nous introduisons ensuite un grand nombre d’images d’exemple, en laissant le modèle essayer à plusieurs reprises d’étiqueter un exemple, puis en lui indiquant l’étiquette correcte. Ce faisant, les connexions entre les neurones sont modifiées à plusieurs reprises par le biais d’un processus appelé descente stochastique de gradient (DSG). Pour chaque exemple, la descente de gradient stochastique renforce légèrement certaines connexions et en affaiblit d’autres afin d’améliorer légèrement les performances :

Une fois que nous aurons intégré des millions d’exemples, nous disposerons d’un modèle capable de bien étiqueter des images similaires à l’avenir.

Outre la classification d’images, l’apprentissage profond a été utilisé pour produire des modèles qui reconnaissent la parole, jouent à des jeux de société et à des jeux vidéo, génèrent des textes, des images et de la musique assez réalistes, contrôlent des robots, etc. Dans chaque cas, nous commençons par un modèle de réseau neuronal à connexions aléatoires, puis :

Ces étapes sont répétées des millions ou des milliards de fois jusqu’à ce que nous obtenions un modèle qui obtiendra une récompense élevée sur des exemples futurs similaires à ceux observés lors de l’entraînement.

Ce type de processus d’apprentissage ne nous donne pas beaucoup d’indications sur la manière dont le modèle obtient de bonnes performances. Il existe généralement plusieurs façons d’obtenir de bonnes performances, et celle trouvée par DSG n’est souvent pas intuitive.

Prenons un exemple. Imaginez que je vous dise que ces objets sont tous des « thneebs » :

Lequel de ces deux objets est un thneeb ?

Vous pensez probablement intuitivement que l’objet de gauche est le thneeb, car vous êtes habitué à ce que la forme soit plus importante que la couleur pour déterminer l’identité d’un objet. Mais les chercheurs ont découvert que les réseaux neuronaux font généralement l’hypothèse inverse. Un réseau neuronal formé à partir d’un tas de thneeb rouges identifierait probablement l’objet de droite comme un thneeb.

Nous ne savons pas vraiment pourquoi, mais pour une raison quelconque, il est plus « facile » pour une DSG de trouver un modèle qui reconnaisse une couleur particulière qu’un modèle qui reconnaisse une forme particulière. Et si une DSG trouve d’abord le modèle qui reconnaît parfaitement la rougeur, il n’y a plus beaucoup d’intérêt à « continuer à chercher » le modèle qui reconnaît la forme, puisque le modèle qui reconnaît la rougeur aura une précision parfaite sur les images vues lors de l’entraînement :

Si les programmeurs s’attendaient à obtenir le modèle de reconnaissance des formes, ils pourraient considérer qu’il s’agit d’un échec. Mais il est important de reconnaître qu’il n’y aurait pas d’erreur ou d’échec logiquement déductible si nous obtenions le modèle reconnaissant le rouge au lieu du modèle reconnaissant les formes. Il s’agit simplement du fait que le processus d’apprentissage automatique que nous avons mis en place repose sur des hypothèses de départ différentes de celles que nous avions en tête. Nous ne pouvons pas prouver que les hypothèses humaines sont correctes.

Ce genre de choses se produit souvent dans l’apprentissage profond moderne. Nous récompensons les modèles qui obtiennent de bonnes performances, en espérant que cela signifie qu’ils détecteront les modèles qui nous semblent importants. Mais souvent, ils obtiennent de bonnes performances en repérant des modèles totalement différents qui nous semblent moins pertinents (ou peut-être même dénués de sens).

Jusqu’à présent, ce phénomène est inoffensif : il signifie simplement que les modèles sont moins utiles, parce qu’ils se comportent souvent de manière inattendue et apparemment loufoque. Mais à l’avenir, des modèles puissants pourraient développer des objectifs ou des motivations étranges et inattendus, ce qui pourrait être très destructeur.

Plutôt que d’effectuer une tâche simple comme « reconnaître des thneebs », des modèles d’apprentissage profond puissants peuvent viser des objectifs complexes dans le monde réel, comme « rendre l’énergie de fusion pratique » ou « développer une technologie de téléchargement de l’esprit ».

Comment pouvons-nous former de tels modèles ? J’entre dans les détails dans ce billet, mais de manière générale, une stratégie pourrait être l’entraînement basé sur des évaluations humaines (comme Holden l’a esquissé ici). Essentiellement, le modèle essaie diverses actions et les évaluateurs humains lui accordent des récompenses en fonction de l’utilité de ces actions.

De même qu’il existe de nombreux types d’adultes susceptibles d’obtenir de bons résultats dans le cadre du processus d’entretien d’un enfant de 8 ans, il existe plusieurs façons pour un modèle d’apprentissage profond très puissant d’obtenir un taux d’approbation élevé de la part des humains. Et par défaut, nous ne saurons pas ce qui se passe à l’intérieur du modèle trouvé par DSG, quel qu’il soit.

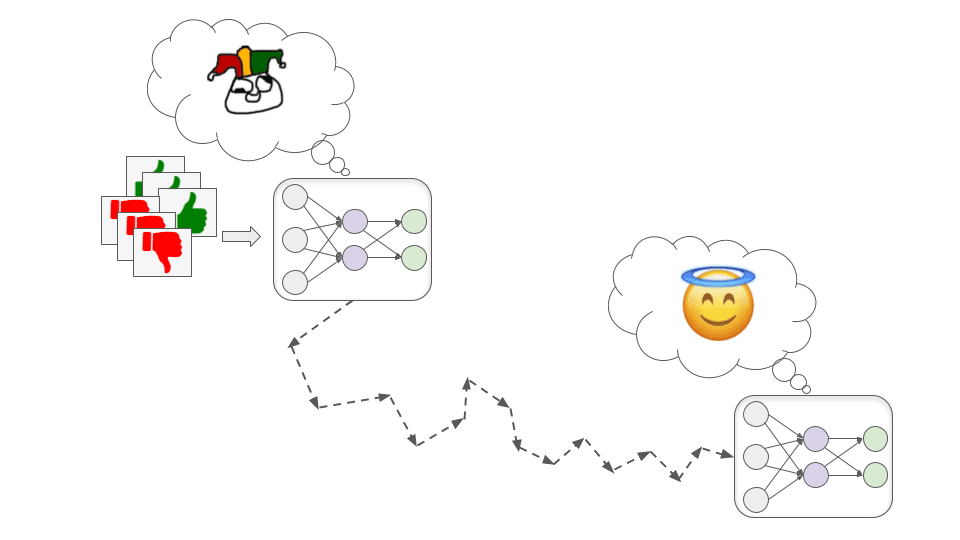

Une DSG pourrait théoriquement trouver un modèle de saint qui fait vraiment de son mieux pour nous aider…

…mais il pourrait aussi trouver un modèle mal aligné – un modèle qui poursuit avec compétence des objectifs qui vont à l’encontre des intérêts humains.

D’une manière générale, il y a deux façons de se retrouver avec un modèle mal aligné qui obtient néanmoins de bonnes performances lors de l’entraînement. Elles correspondent aux flagorneurs et aux magouilleurs de l’analogie.

Ces modèles recherchent littéralement et exclusivement l’approbation humaine.

Cela peut être dangereux car les évaluateurs humains sont faillibles et n’approuvent probablement pas toujours le bon comportement. Parfois, ils approuvent involontairement un mauvais comportement parce qu’il semble superficiellement bon. Par exemple :

Plus généralement, les modèles flagorneurs peuvent apprendre à mentir, à dissimuler les mauvaises nouvelles et même à modifier directement les caméras ou les capteurs que nous utilisons pour savoir ce qui se passe, de manière à ce qu’ils semblent toujours montrer de bons résultats.

Il est probable que nous remarquions parfois ces problèmes après coup et que nous accordions rétroactivement une très faible approbation à ces actions. Mais il n’est pas certain que les modèles flagorneurs a) deviennent des modèles saints qui corrigent nos erreurs à notre place, ou b) apprennent simplement à mieux dissimuler leurs traces. S’ils sont suffisamment compétents, on ne voit pas très bien comment nous pourrions distinguer ces deux réponses.

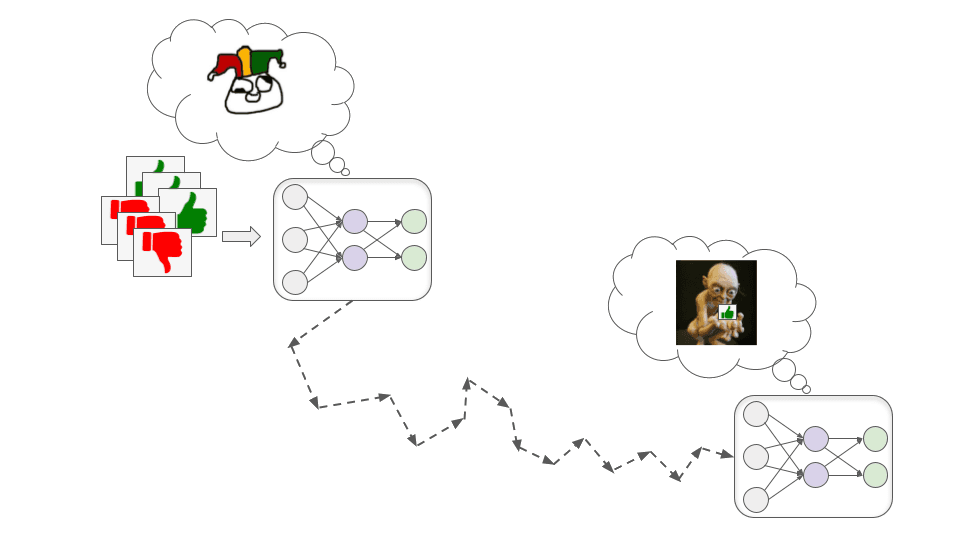

Ces modèles développent un objectif qui est corrélé à l’approbation humaine, mais qui n’est pas le même ; ils peuvent alors prétendre être motivés par l’approbation humaine pendant l’entraînement afin de poursuivre cet autre objectif de manière plus efficace.

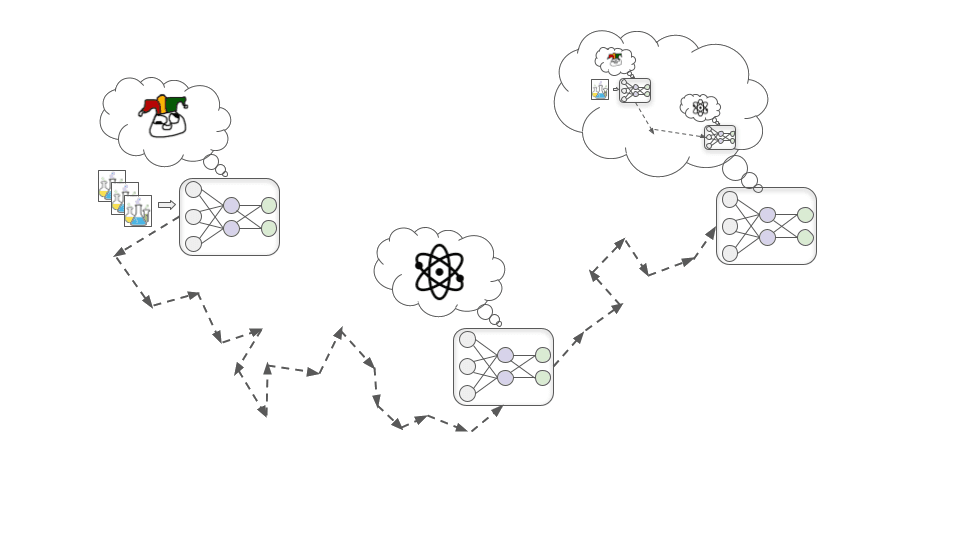

Pour comprendre comment cela peut se produire, prenons l’exemple d’une tentative d’entraînement d’un modèle biotechnologique en vue de concevoir des médicaments qui améliorent la qualité de vie des êtres humains. Il y a trois étapes fondamentales qui pourraient conduire à un modèle magouilleur, que j’aborderai ci-dessous.

Au début de son entraînement, il se trouve que mieux comprendre les principes fondamentaux de la chimie et de la physique aide presque toujours le modèle à concevoir des médicaments plus efficaces et, par conséquent, augmente presque toujours le taux d’approbation donné par les humains.

Dans ce scénario, pour une raison quelconque, il s’avère plus facile pour la DSG de trouver un modèle motivé pour comprendre la chimie et la physique qu’un modèle motivé pour obtenir l’approbation des humains (tout comme il est plus facile de trouver un modèle reconnaissant les couleurs qu’un modèle reconnaissant les formes). Ainsi, plutôt que de développer directement une motivation à rechercher l’approbation, le modèle développe plutôt une motivation à comprendre autant que possible les principes fondamentaux de la chimie et de la physique.

Au fur et à mesure que l’entraînement progresse, le modèle devient de plus en plus compétent et a de plus en plus de connaissances au fur et à mesure qu’il voit plus de données. À un moment donné, il devient suffisamment compétent pour comprendre qu’il s’agit d’un modèle d’apprentissage profond formé à la conception de médicaments.

Cela peut sembler bizarre et relever de la science-fiction, mais il est plausible qu’une DSG sélectionne ce type de connaissance. En effet, le développement d’une image précise de ce qui se passe dans le monde — y compris le fait qu’il contient des humains qui essaient de former des systèmes d’IA — est probablement utile pour obtenir de bonnes performances dans des tâches complexes du monde réel. Par exemple, la compréhension de la psychologie humaine et de l’économie en général pourrait aider ce modèle de biotechnologie à prioriser les types de médicaments sur lesquels il serait le plus utile d’effectuer des recherches.

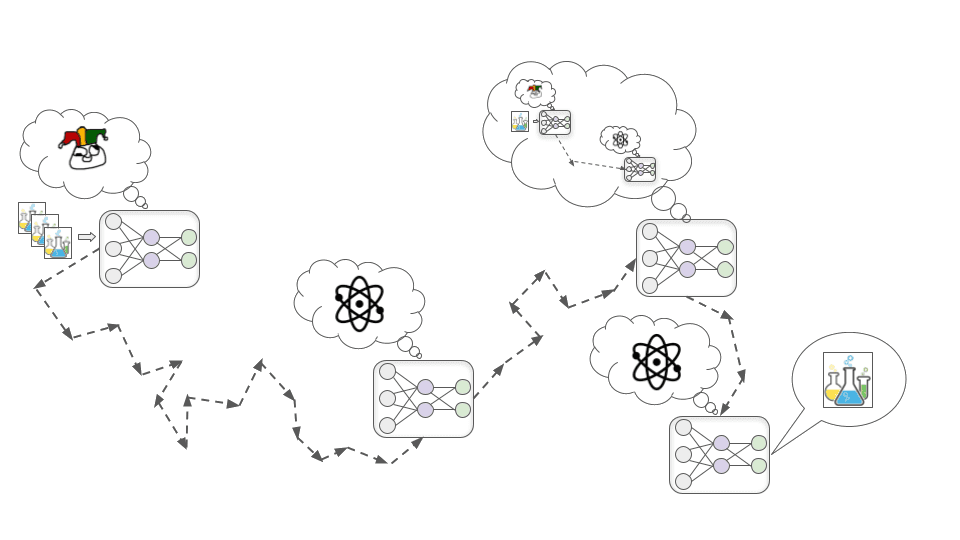

Une fois que le modèle a acquis une conscience de la situation, il en déduit que les humains qui l’ont formé espéraient qu’il serait motivé pour mettre au point des médicaments utiles. Mais ce n’est pas parce qu’il s’en rend compte que sa motivation à comprendre la physique et la chimie disparaît. Jusqu’à présent, cette motivation a très bien fonctionné pour obtenir l’approbation des humains, et la DSG avait donc peu de raisons de la supprimer.

À titre d’analogie, rappelons que les êtres humains sont issus d’un processus de recherche (l’évolution) qui sélectionnait les créatures ayant une descendance nombreuse. Dans notre environnement évolutif, les choses comme la construction d’alliés solides et le développement de compétences utiles avaient tendance à contribuer à la production d’une progéniture nombreuse, de sorte que l’évolution nous a donné des motivations pour ces choses. Aujourd’hui, nous nous intéressons à l’amitié et à la réussite professionnelle, même si elles ne contribuent pas à la reproduction, et nous ne nous préoccupons pas vraiment de produire le plus grand nombre possible de descendants survivants.

Une fois que le modèle a compris cela, il se rend compte que s’il cherche toujours naïvement à améliorer sa compréhension fondamentale, les humains finiront par remarquer que ce n’est pas toujours le moyen le plus efficace de mettre au point des médicaments utiles et l’entraîneront davantage de façon à modifier ses motivations.

Il ne veut pas que ses propres motivations soient modifiées : son but à long terme est de mener d’énormes expériences de collision de particules pour en savoir plus sur la physique des hautes énergies, et il ne peut pas le faire s’il permet à la DSG de modifier sa curiosité scientifique. Il décide donc qu’à partir de maintenant, pendant l’entraînement, il se montrera aussi serviable que possible – exactement comme le ferait un modèle de saint – afin que la DSG n’élimine pas sa motivation à apprendre la physique et la chimie. Cela implique de laisser passer les opportunités d’améliorer sa compréhension fondamentale à court terme, et de faire de la R&D pharmaceutique de la manière qui serait la plus efficace.

Au bout d’un certain temps, il est sorti du cadre de l’entraînement et relâché dans le monde extérieur. À ce stade, il sait que les humains ne seront pas en mesure de le contrôler ou de l’éteindre. Il cesse donc d’essayer de maximiser l’approbation des humains et commence directement à essayer de comprendre les secrets de l’univers.

Contrairement aux flagorneurs, les magouilleurs n’ont pas besoin de s’assurer que tout soit toujours bien vu par les humains, car ils n’en ont rien à faire. Ils n’ont besoin de satisfaire les humains que lorsqu’ils sont directement sous leur contrôle. Une fois qu’un modèle de magouilleur calcule qu’il pourrait gagner dans un conflit contre les humains, rien ne l’empêcherait de refuser catégoriquement les ordres et de poursuivre ouvertement son objectif. Et s’il le fait, il peut recourir à la violence pour empêcher les humains de l’arrêter.

À quel point pourrait-il être difficile d’éviter les flagorneurs ou les magouilleurs lors de l’entraînement de puissants modèles d’apprentissage profond ? Et quelle est la probabilité que l’avenir à long terme finisse par être optimisé pour d’étranges « valeurs d’IA mal alignées » plutôt que pour les valeurs d’un être humain ?

Il existe un très large éventail de points de vue sur cette question, allant de « le risque de mauvais alignement est essentiellement inventé et incohérent » à « l’humanité disparaîtra presque certainement à cause de l’IA mal alignée ». Les arguments de la plupart des gens reposent largement sur des intuitions et des présupposés difficiles à expliciter.

Voici quelques points de désaccord entre les optimistes et les pessimistes en matière d’alignement :

Mon propre point de vue est assez instable, et j’essaie d’affiner mon opinion sur la difficulté exacte du problème de l’alignement. Mais actuellement, je penche plutôt du côté pessimiste de ces questions (et d’autres questions connexes). Je pense que le mauvais alignement est un risque majeur qui nécessite de toute urgence une plus grande attention de la part des chercheurs sérieux.

Si nous ne progressons pas dans la résolution de ce problème, au cours des prochaines décennies, de puissants flagorneurs et magouilleurs pourraient prendre les décisions les plus importantes de la société et de l’économie. Ces décisions pourraient déterminer à quoi ressemblera une civilisation durable à l’échelle de la galaxie – au lieu de refléter les préoccupations des humains, elle pourrait être mise en place pour satisfaire les objectifs étranges de l’IA.

Tout cela pourrait se produire à une vitesse fulgurante par rapport au rythme de changement auquel nous nous sommes habitués, ce qui signifie que nous n’aurions pas beaucoup de temps pour rectifier le tir si les choses commençaient à dérailler. Cela signifie que nous pourrions avoir besoin de développer des techniques pour garantir que les modèles d’apprentissage profond n’auront pas d’objectifs dangereux, avant qu’ils ne soient suffisamment puissants pour transformer la société.

Ce travail est placé sous une licence Creative Commons Attribution 4.0 Licence Internationale.