Pourquoi nous devons réduire les risques existentiels

En 1939, Einstein écrivait à Roosevelta :

Il est peut-être possible de déclencher une réaction nucléaire en chaîne dans une grande masse d’uranium… et il est concevable — bien que plus incertain — que des bombes extrêmement puissantes d’un nouveau type puissent ainsi être construites.

A peine cinq ans plus tard, ces bombes avaient été créées. En un peu plus d’une décennie, une quantité suffisante en avait été produite pour qu’une poignée de décideurs soit capable de détruire notre civilisation — une première dans l’histoire de l’humanité.

Nous venions d’entrer dans une nouvelle ère, une ère dans laquelle nous serions confrontés non seulement à des risques existentielsb liés à notre environnement naturel, mais aussi à la possibilité de nous éradiquer nous-mêmes.

Dans cette nouvelle ère, quelle devrait être notre plus grande priorité en tant que civilisation ? Les avancées technologiques ? L’aide aux plus pauvres ? Changer le système ?

Voici une suggestion qui n’est pas si souvent discutée : notre plus grande priorité devrait être de survivre.

Tant que la civilisation continue d’exister, tous les autres problèmes ont une chance d’être résolus, et nous d’avoir un avenir bien meilleur. Mais si nous nous éteignons, tout est fini.

Pourquoi cette priorité n’est-elle pas davantage discutée ? Voici une raison : beaucoup de personnes ne se rendent pas encore compte que les choses ont changé. Ils ne réalisent donc pas que notre avenir est en danger.

Spencer Greenberg, chercheur en sciences sociales, a mené une enquête auprès d’un échantillon d’Américains. Il voulait connaître la probabilité, selon eux, d’une extinction de l’humanité dans les 50 prochaines années. Le résultat : beaucoup pensent que la probabilité d’une extinction est extrêmement faible, plus de 30 % d’entre eux estimant qu’elle est inférieure à 0,0001 % — une chance sur dix millionsc.

Nous, à 80 000 Hours, pensions aussi que les risques étaient extrêmement faibles, mais une fois que nous nous sommes renseignés, nous avons changé d’avis. Comme vous le verrez dans la suite de l’article, les chercheurs qui étudient ces questions estiment que les risques sont plus de 1 000 fois supérieurs et qu’en toute probabilité, ils ne font qu’augmenter.

Ces préoccupations ont donné naissance à un nouveau mouvement œuvrant pour la préservation de la civilisation, auquel se sont joints entre autres Stephen Hawking, Max Tegmark et de nouveaux instituts fondés par des chercheurs des universités de Cambridge et d’Oxford, du MIT, et d’ailleurs.

Dans la suite de cet article, nous aborderons les plus grands risques pour notre civilisation, dont certains pourraient être plus importants encore que la guerre nucléaire et le changement climatique. Nous tenterons ensuite de démontrer que la réduction de ces risques pourrait être le projet le plus important que vous puissiez entreprendre, et nous expliquerons ce que vous pouvez faire pour y contribuer.

Une probabilité d’extinction de 1 sur 10 millions dans les 50 prochaines années — l’estimation faite par plus de 30 % des personnes interrogées par Spencer Greenberg — sous-estime très probablement le risque véritable. Les menaces existentielles d’origine naturelle à elles seules ont une probabilité d’advenir plus élevées que ça : elles peuvent être estimées assez précisément sur la base de données historiques.

Si la Terre était frappée par un astéroïde d’un kilomètre de large, notre civilisation pourrait être détruite. En examinant les données historiques et en suivant les trajectoires des objets dans le ciel, les astronomes peuvent estimer le risque qu’un astéroïde de cette taille frappe la Terre : environ 1 chance sur 5 000 par siècled. C’est supérieur à la probabilité de la plupart d’entre nous de se retrouver dans un accident d’avion (environ 1 chance sur 5 millions par vol), mais surtout, ce seul risque est déjà 1 000 fois plus probable que le risque d’extinction estimé par certains à 1 chance sur 10 millionse.

Certains arguent néanmoins que même si un astéroïde d’un kilomètre serait une catastrophe, il ne suffirait pas à provoquer notre extinction, et qu’il s’agit donc d’une estimation élevée du risque. Mais d’un autre côté, il existe d’autres menaces d’origine naturelle, par exemple les super-volcansf.

Cela étant dit, les risques naturels restent assez faibles, dans l’absolu. Un article à paraître du Dr Toby Ord estime que si nous additionnons tous les risques naturels, il est très peu probable qu’ils représentent plus d’une chance sur 300 d’extinction par siècle1.

Malheureusement, comme nous allons le montrer, les risques naturels sont éclipsés par les risques dus à l’humanité elle-même. C’est pourquoi le risque d’extinction est devenu une question particulièrement urgente.

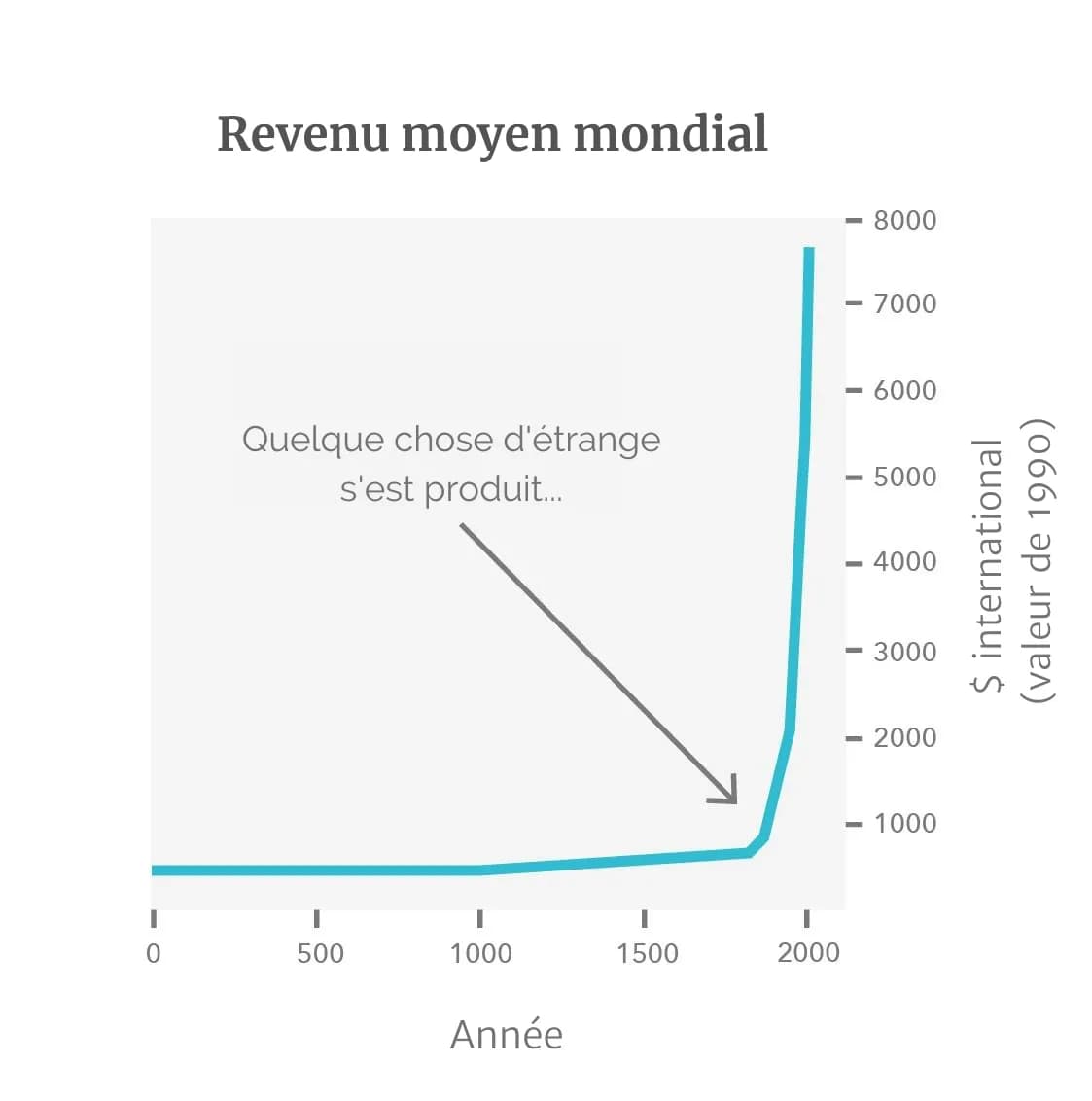

Quand on prend du recul, le message fondamental qui ressort de nos millénaires d’histoire est le suivant : pendant longtemps, on était presque tous pauvres, puis le 18ème siècle est arrivé et tout a changé2.

La cause de ce changement, c’est la révolution industrielle — candidate au titre d’événement le plus important de notre histoire.

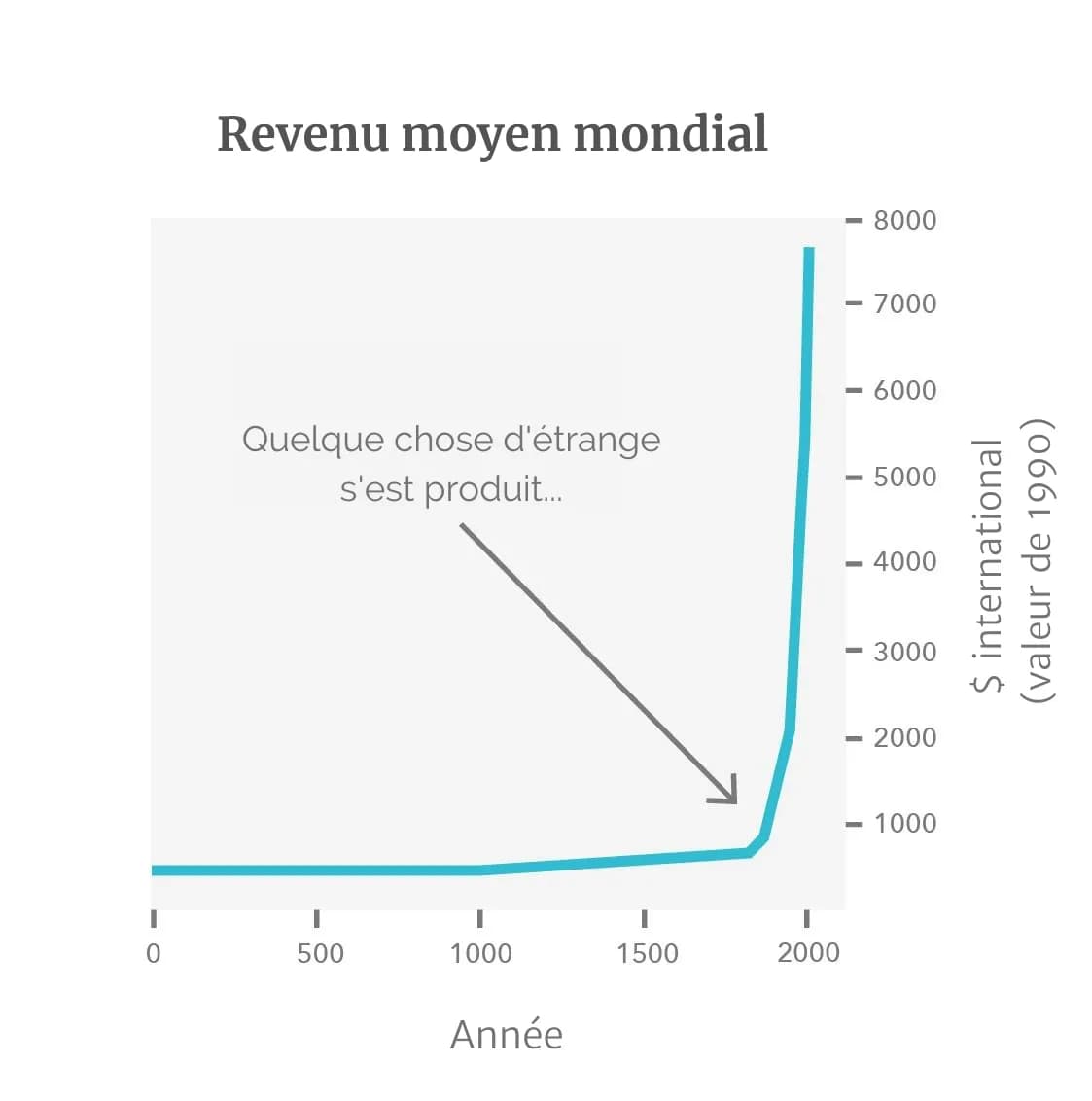

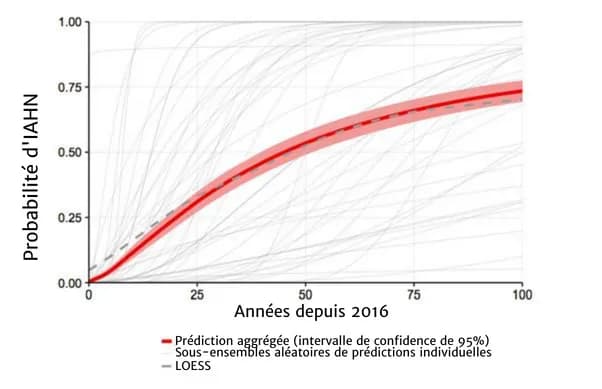

Ce n’est pas seulement notre prospérité qui a augmenté. Le graphique qui suit montre que sur le long terme, l’espérance de vie, la consommation d’énergie et le nombre de personnes vivant en démocratie ont toutes augmenté rapidement, tandis que le pourcentage de personnes vivant dans l’extrême pauvreté a considérablement diminué3.

Les niveaux d’alphabétisation et d’éducation ont également augmenté de façon spectaculaire :

Les gens semblent également devenir plus heureux au fur et à mesure qu’ils deviennent plus prospères.

Dans The Better Angels of Our Nature, l’intellectuel Steven Pinker affirme que la violence est aussi en baisse. (Même si le podcast de 80,000 Hours avec Bear Braumoeller examine un ensemble d’arguments qui contredisent cette hypothèse.)

La liberté individuelle a augmenté, tandis que le racisme, le sexisme et l’homophobie ont diminué.

Beaucoup de personnes pensent que le monde va de plus en plus malg, et il est vrai que la civilisation moderne se livre à des actes terribles — par exemple l’élevage industriel. Mais comme vous pouvez le voir dans les données présentées, on constate un progrès spectaculaire sur de nombreuses mesures.

Surtout, peu importe ce que vous pensez des événements passés, si nous regardons vers l’avenir, l’amélioration de la technologie, de l’organisation politique et de la liberté donne à nos descendants la possibilité de résoudre nos problèmes actuels et d’avoir une vie bien meilleureh. Il est possible de mettre fin à la pauvreté, de prévenir le changement climatique, d’atténuer la souffrance, etc.

Mais notez également la ligne violette du deuxième graphique : notre capacité à faire la guerre. Elle est basée sur les estimations de l’historien Ian Morris concernant la puissance militaire mondiale, et elle a également augmenté de façon spectaculaire.

C’est là le problème : le perfectionnement de la technologie permet des progrès immenses, mais crée aussi des risques immenses.

Quand nous découvrons une nouvelle technologie, elle apporte la plupart du temps de grands bénéfices… mais il y a toujours un risque que nous découvrions une technologie dont le pouvoir destructeur est supérieur à ce que nous sommes capables d’utiliser à bon escient.

Ainsi, bien que la génération actuelle vive dans la période la plus prospère de l’histoire de l’humanité, il est plausible que cette période faste soit aussi la plus dangereuse.

La première technologie destructrice de ce type ? L’arme nucléaire.

Aujourd’hui, nous avons tous en tête le programme nucléaire de la Corée du Nord ou de la Russie, mais les événements actuels ne sont qu’un unique chapitre dans une longue saga d’accidents évités de justesse.

Nous avons frôlé la guerre nucléaire à plusieurs reprises au cours de la crise des missiles cubains à elle seule4. Un jour, les Américains décrétèrent que si un de leurs avions espions était abattu, ils envahiraient immédiatement Cuba sans même réunir leur Conseil de guerre. Le jour suivant, un avion espion fut abattu. JFK convoqua le Conseil malgré tout et décida de ne pas lancer une invasion.

Une invasion de Cuba aurait très bien pu déclencher une guerre nucléaire ; on apprit par la suite que Castro était favorable à des représailles nucléaires même si « ça aurait conduit à l’anéantissement de Cuba ». En cas d’invasion, certains des individus responsables du lancement des missiles à Cuba avaient également le droit de cibler les forces américaines avec des armes nucléaires tactiques.

Lors d’un autre incident, un sous-marin nucléaire russe tenta d’amener clandestinement du matériel sur le territoire cubain. Il fut découvert par la flotte américaine. La flotte largua des grenades sous-marines factices pour forcer le sous-marin à faire surface. Le capitaine russe crut qu’il s’agissait de vraies grenades et que, pendant la période où son sous-marin avait perdu le contact radio, la troisième guerre mondiale s’était déclarée. Il ordonna l’utilisation d’une de leurs torpilles nucléaires contre la flotte américaine.

Heureusement, il avait besoin de l’approbation d’autres officiers supérieurs. L’un d’eux, Vasili Arkhipov, ne donna pas son accord, empêchant ainsi le début d’une guerre qui, elle, aurait été bien réelle.

En mettant tous ces événements bout à bout, le président américain John F. Kennedy estima par la suite qu’au cours de cette période, les chances d’une guerre nucléaire furent comprises entre 33 % et 50 %i.

Même après la guerre froide, on compta bien d’autres incidents avec la Russie, comme le montre cette belle page Wikipédia. Et ce ne sont que les exemples qui nous sont connus.

Aujourd’hui, les experts nucléaires sont tout aussi préoccupés par les tensions entre l’Inde et le Pakistan, qui possèdent tous deux l’arme nucléaire, tout comme la Corée du Nordj.

Le principal problème est que plusieurs pays disposent d’importants arsenaux nucléaires qu’ils peuvent déployer en une poignée de minutes. Ce qui signifie qu’une fausse alerte ou un accident peut rapidement dégénérer en guerre nucléaire, surtout quand les relations internationales sont tendues.

Est-ce qu’une guerre nucléaire mettrait fin à notre civilisation ? On a d’abord pensé qu’une explosion nucléaire dégagerait une telle chaleur qu’elle enflammerait l’atmosphère et rendrait la Terre inhabitable. Les scientifiques d’alors estimèrent qu’un tel scénario était suffisamment improbable pour que les armes puissent être testées « en toute sécurité », et nous savons maintenant qu’ils avaient raison.

Dans les années 1980, on craignait que les cendres de bâtiments en feu après une attaque ne plongent la Terre dans un hiver prolongé qui rendrait impossible toute agriculture pendant des décenniesk. Les modèles climatiques modernes suggèrent qu’un hiver nucléaire suffisamment grave pour nous tuer tous est très improbable, bien qu’il soit difficile d’être sûr en raison de la variabilité des paramètres de modélisationsl.

Cependant, même un hiver nucléaire « doux » pourrait provoquer une famine massivem. Pour cette raison, entre autres, une guerre nucléaire serait extrêmement déstabilisante et il n’est pas certain que notre civilisation pourrait s’en remettre.

Quelle est la probabilité qu’une guerre nucléaire mette définitivement fin à la civilisation humaine ? C’est très complexe à estimer, mais il est difficile d’estimer la probabilité d’un tel événement à moins de 0,3 % au cours du prochain siècle — ce qui est la probabilité estimée par Toby Ord de notre extinction au cours du prochain siècle à cause d’un risque naturel. Cela signifie que les risques liés à l’arme nucléaire sont plus importants que tous les risques naturels réunis. (En savoir plus sur les dangers nucléaires.)

C’est pourquoi les années 1950 ont marqué le début d’une nouvelle ère pour l’humanité. Pour la première fois dans notre histoire, il est devenu envisageable pour un petit nombre de décideurs de faire des ravages dans le monde entier. Nous représentons désormais la plus grande menace pour notre propre survie — ce qui fait du moment présent le plus dangereux de l’histoire de l’humanité.

Et l’arme nucléaire n’est pas notre seul moyen de condamner notre civilisation.

En 2015, le président Obama déclara dans son discours annuel sur l’état de l’Union qu’« aucun défi ne constitue une plus grande menace pour les générations futures que le changement climatique ».

Le changement climatique est effectivement un risque majeur pour notre civilisation.

Son résultat le plus probable est un réchauffement de 2 à 4 degrés5 — une situation néfaste, mais que notre espèce survivrait.

Toutefois, certaines estimations attribuent une probabilité de 10 % à un réchauffement supérieur à 6 degrés, et même une probabilité de 1 % à un réchauffement de 9 degrés.

Il semble donc que la probabilité d’une catastrophe climatique majeure due au CO2 soit comparable à celle d’une guerre nucléaire.

Mais comme nous, à 80,000 Hours, l’affirmons dans notre dossier sur le changement climatique, il semble peu probable que le réchauffement, même s’il atteint 13 degrés, entraîne directement l’extinction de l’humanité. En conséquence, les chercheurs qui étudient ces questions pensent qu’une guerre nucléaire est plus susceptible d’entraîner une extinction pure et simple, en raison de la possibilité d’un hiver nucléaire. C’est pourquoi tout porte à croire que l’arme nucléaire représente un risque encore plus grand que le changement climatique.

Cela dit, le changement climatique reste un problème majeur, et ses effets déstabilisants pourraient exacerber d’autres risques (notamment les risques de conflit nucléaire). Ces effets de second ordre doivent nous inciter à augmenter encore davantage notre estimation du risque d’extinction dû à un conflit nucléaire.

L’invention de l’arme nucléaire a donné naissance au mouvement antinucléaire vingt ans plus tard, dans les années 1960, et le mouvement écologiste a rapidement adopté la cause de la lutte contre le changement climatique.

Ce que l’on sait moins, c’est que les nouvelles technologies vont conduire à de nouveaux risques de catastrophe planétaire. C’est pourquoi nous avons besoin d’un mouvement concentré sur la sauvegarde de la civilisation dans son ensemble, quel que soit le type de risques.

Il est difficile de prédire l’avenir de la technologie, mais comme nous n’avons qu’une seule civilisation, nous devons faire de notre mieux. Voici quelques candidats potentiels au titre de future technologie dévastatrice, et tous pourraient être aussi dangereux que l’arme nucléaire.

En 1918–1919, plus de 3 % de la population mondiale meurt de la grippe espagnolen. Si une telle pandémie survenait aujourd’hui, la rapidité des transports mondiaux la rendrait encore plus difficile à contenir.

Ce qui est plus inquiétant, c’est que grâce à des manipulations génétiques, il pourrait bientôt être possible de créer un virus aussi contagieux et encore plus mortel que la grippe espagnole, capable de se propager pendant des années sans être détecté.

Ce serait une arme avec le pouvoir destructeur de l’arme nucléaire mais dont l’usage serait bien plus difficile à prévenir. Pourquoi ? Parce que la fabrication des armes nucléaires nécessite d’énormes usines et des matériaux rares, ce qui la rend relativement facile à contrôler. En revanche, une poignée de docteurs en biologie dans leur laboratoire pourraient être capables de synthétiser de nouveaux virus. Le journal The Guardian a d’ailleurs reçu en 2006 des échantillons du virus disparu de la variole, envoyés par la poste6. Certains groupes terroristes ont aussi exprimé leur intérêt pour l’utilisation d’armes biologiques. (Pour en savoir plus sur les risques de pandémie.

Une autre nouvelle technologie au potentiel considérable est l’intelligence artificielle.

Si ce sont les humains qui sont aux commandes du monde et non les chimpanzés, c’est une question d’intelligence. Nos cerveaux plus grands et plus puissants nous permettent de contrôler le monde qui nous entoure à un degré remarquable, même si nous sommes bien plus faibles physiquement que les chimpanzés.

Alors que se passerait-il si nous arrivions à fabriquer quelque chose de bien plus intelligent que nous ?

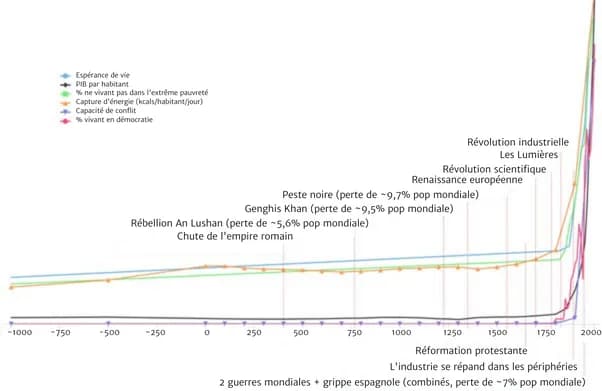

En 2017, 350 chercheurs — sélectionnés pour avoir publié des articles sur l’intelligence artificielle dans des conférences de premier plan — ont été interrogés sur la date à laquelle, selon eux, nous développerons des ordinateurs dotés d’une intelligence de niveau humain, c’est-à-dire une machine capable d’effectuer toutes les tâches professionnelles mieux qu’un humain.

L’estimation médiane assignait une probabilité de 50 % — une chance sur deux — au développement d’une intelligence artificielle de haut niveau dans 45 ans, et 75 % d’ici la fin du siècle7.

Ces probabilités sont difficiles à estimer et les chercheurs donnèrent des chiffres très différents en fonction de la formulation exacte de la questiono. Néanmoins, leurs chiffres indiquent une chance raisonnable qu’une intelligence artificielle transformatrice soit développée au cours du siècle prochain. En outre, l’incertitude qui entoure ces prédictions implique qu’elle pourrait arriver plus tôt que ce qu’on croit.

Quels risques cette évolution présente-t-elle ? Les pionniers de l’informatique, comme Alan Turing et Marvin Minsky, se sont inquiétés des risques liés aux systèmes informatiques puissantsp et ces risques existent toujours aujourd’hui. Il ne s’agit pas de voir les ordinateurs devenir malfaisants comme dans Terminator. La crainte est plutôt qu’un système d’IA puissant soit utilisé par un groupe d’individus pour prendre le contrôle du monde entier, ou qu’il soit utilisé à mauvais escient. Si l’URSS avait développé l’arme nucléaire 10 ans avant les États-Unis, elle serait peut-être devenue la puissance mondiale dominante. Les technologies informatiques puissantes pourraient présenter des risques et enjeux similaires.

Une autre préoccupation est que le déploiement de cette IA puissante pourrait avoir des conséquences inattendues, puisqu’il est difficile de prévoir ce que ferait une chose plus intelligente que nous. Un système suffisamment puissant pourrait également être difficile à contrôler, et donc à débrancher une fois mis en œuvre. Ces préoccupations ont été documentées par Nick Bostrom, professeur à Oxford, dans son livre Superintelligence et par Stuart Russell, pionnier de l’IA.

La plupart des experts pensent que l’amélioration de l’IA sera une évolution extrêmement positive, mais ils reconnaissent qu’il existe des risques. Dans l’enquête que nous venons de mentionner, les experts en IA ont estimé que le développement d’une intelligence artificielle de haut niveau avait 10 % de chance d’aboutir à un « mauvais scénario » et 5 % à un scénario « extrêmement mauvais », comme l’extinction de l’humanitéq. Et nous devrions probablement nous attendre à ce que ce groupe d’experts souffre d’un biais d’optimisme puisque, après tout, il tire sa subsistance de cette technologie.

Quand on combine ces estimations, s’il y a 75 % de chances qu’une intelligence artificielle de haut niveau soit développée au cours du siècle prochain, cela signifie que la probabilité d’une catastrophe majeure liée à l’IA est 5 % de 75 %, soit environ 4 %. (Pour en savoir plus sur les risques liés à l’intelligence artificielle).

D’autres nouvelles technologies, telles que des formes de géo-ingénierie et les nanotechnologies, ont suscité des inquiétudes, mais elles semblent moins imminentes et sont donc généralement considérées comme moins dangereuses. Vous pouvez consulter une liste de risques existentiels plus longue, qui comprend ces technologies, ici.

Ce qui est plus inquiétant, ce sont les risques auxquels nous n’avons pas encore pensé. Si vous aviez demandé en 1900 quels étaient les plus grands risques pour la civilisation, on ne vous aurait probablement pas suggéré l’arme nucléaire, le génie génétique ou l’intelligence artificielle, puisque rien de tout cela n’avait été inventé. Il est possible que nous soyons dans la même situation par rapport au siècle prochain. Les futures « inconnues inconnues », ces risques dont nous ne réalisons même pas qu’ils pourraient exister, sont peut-être un risque plus important que les risques que nous connaissons déjà aujourd’hui.

Chaque fois que nous découvrons une nouvelle technologie, c’est un peu comme de parier contre un numéro à la roulette. La plupart du temps, on gagne, et la technologie a un impact positif dans l’ensemble. Mais à chaque fois, il y a une petite chance que cette technologie nous offre un pouvoir destructeur supérieur à ce que nous sommes capables de gérer, et nous perdons tout.

De nombreux experts qui étudient ces questions estiment que le risque total d’extinction de l’humanité au cours du prochain siècle se situe entre 1 et 20 %.

Dans un épisode du podcast de 80,000 Hours avec le philosophe William MacAskill, nous discutons des raisons pour lesquelles il place ce risque autour de 1 %.

Et dans son livre The Precipice (Le Précipice : le risque existentiel et l’avenir de l’humanité), le philosophe Toby Ord estime que notre risque existentiel total pour ce siècle est de 1 sur 6, ou environ 17 % — autant dire un lancé de dé (il faut cependant noter que la définition faite par Ord d’une catastrophe existentielle n’est pas exactement équivalente à l’extinction de l’humanité ; elle inclut par exemple une catastrophe planétaire dont notre espèce serait incapable de se remettre complètement, même si nous n’étions pas éradiqués). Écouter l’épisode avec Toby.

Dans son livre, le tableau suivant présente ses estimations (très approximatives) du risque existentiel dû, selon lui, aux menaces les plus sérieuses :

| Catastrophe existentielle à cause de… | Probabilité d’advenir d’ici un siècle |

|---|---|

| Impact d’un astéroïde ou d’une comète | ~1 sur 1 milliard |

| Eruption d’un supervolcan | ~1 sur 10 000 |

| Explosion stellaire | ~1 sur 1 000 milliards |

| Risque naturel total | ~1 sur 10 000 |

| Guerre nucléaire | ~1 sur 1 000 |

| Changement climatique | ~1 sur 1 000 |

| Autres dégâts environnementaux | ~1 sur 1 000 |

| Pandémies naturelles | ~1 sur 10 000 |

| Pandémies artificielles | ~1 sur 30 |

| Intelligence artificielle non-alignée avec les valeurs humaines | ~1 sur 10 |

| Risques anthropogéniques imprévus | ~1 sur 30 |

| Autres risques anthropogéniques | ~1 sur 50 |

| Risque anthropogénique total | ~1 sur 6 |

| Risque total | ~1 sur 6 |

Ces chiffres sont un million de fois plus élevés que ce que les gens imaginent en temps normal.

Que doit-on penser de ces estimations ? A priori, les chercheurs qui travaillent sur ces questions le font justement parce qu’ils les jugent importantes. Nous devrions donc nous attendre à ce que leurs estimations soient élevées (c’est un biais de sélection). Mais même si ces chiffres sont débattus, nous à 80 000 Hours pensons qu’une large échelle de points de vue, y compris ceux de MacAskill et d’Orb, sont plausibles.

Quelle priorité doit-on accorder à la réduction de ces risques, par rapport à d’autres enjeux comme la pauvreté dans le monde, la lutte contre le cancer ou l’évolution politique ?

A 80,000 Hours, nous recherchons comment aider les individus à trouver des carrières ayant un impact social positif. Dans ce cadre, nous nous efforçons de trouver les problèmes les plus urgents sur lesquels travailler à travers le monde. Pour cela, nous évaluons divers enjeux mondiaux à l’aide de notre cadre d’analyse, qui les compare en fonction de :

Si on applique ce cadre d’analyse, la sauvegarde de notre avenir commun apparaît, selon nous, comme la plus grande priorité qui soit. Par conséquent, si vous voulez avoir un impact positif conséquent grâce à votre carrière, c’est le domaine le plus important sur lequel vous puissiez vous concentrer.

Dans les prochaines sections de cet article, nous évaluerons ce problème selon les critères de l’ampleur, du délaissement et de la solubilité, en nous appuyant sur l’article Existential risk prevention as global priority (La prévention du risque existentiel comme priorité mondiale) de Nick Bostrom et sur un travail inédit de Toby Ord, ainsi que nos propres recherches.

Tout d’abord, commençons par l’ampleur du problème. Nous avons défendu l’hypothèse qu’il y a probablement plus de 3 % de chance d’extinction au cours du prochain siècle. À quel point est-ce que c’est grave ?

Un chiffre sur lequel nous pouvons nous pencher, c’est celui du nombre de personnes susceptibles de mourir dans une telle catastrophe. La population de la Terre au milieu du siècle sera d’environ 10 milliards d’habitants. Si l’on considère qu’il y a 3 % de chances que tout le monde meure, ça veut dire que l’espérance du nombre de décès, au sens mathématique, est d’environ 300 millions. C’est très probablement davantage que le nombre de morts attendus au cours de ce siècle à cause de maladies liées à la pauvreté, comme le paludismer.

Bon nombre des risques que nous avons évoqués ci-dessus pourraient également provoquer une catastrophe « moyenne » (ce qui est déjà terrible !) plutôt qu’une catastrophe mettant fin à la civilisation — c’est a priori bien plus probable. Selon l’enquête mentionnée plus haut, il y a 10 % de chances qu’une catastrophe tue plus d’un milliard de personnes au cours du prochain siècle, ce qui impliquerait au moins 100 millions de morts supplémentaires au sens de l’espérance mathématique, ainsi que de grandes souffrances endurées par les survivants.

Donc même si l’on ne considère que l’impact sur la génération actuelle, ces risques catastrophiques comptent parmi les problèmes les plus graves auxquels l’humanité se voit confrontée.

Et pourtant, ne prendre en compte que la génération actuelle sous-estime grossièrement l’ampleur du problème. Si la civilisation s’éteint, nous ne perdrons pas que la génération actuelle, mais aussi tout notre avenir.

Nous voulons tous laisser un monde meilleur à nos petits-enfants et la plupart d’entre nous pensons également que nous devrions nous préoccuper davantage des générations futures. Il pourrait y avoir beaucoup plus de personnes menant une vie formidable à l’avenir qu’il n’y a de personnes en vie aujourd’hui, et nous devrions nous préoccuper de leurs intérêts. Il est possible que la civilisation humaine dure des millions d’années : lorsque nous considérons l’impact de risques catastrophiques sur les générations futures, les enjeux sont des millions de fois plus élevés — pour le meilleur ou pour le pire. Comme l’a écrit Carl Sagan dans le magazine américain Foreign Affairs, à propos des conséquences d’une guerre nucléaire8 :

Une guerre nucléaire met en danger tous nos descendants, aussi longtemps qu’il y aura des êtres humains. Même si la population reste statique, avec une durée de vie moyenne de l’ordre de 100 ans, sur une période représentative de l’évolution biologique d’une espèce réussie (environ dix millions d’années), nous parlons de quelque 500 000 milliards de personnes en devenir. Selon ce critère, l’enjeu est un million de fois plus important dans le cas de l’extinction que dans celui, plus modeste, des guerres nucléaires qui ne tuent « que » des centaines de millions de personnes. Il existe de nombreuses autres mesures possibles de cette perte potentielle, notamment à travers la culture et la science, l’histoire évolutive de la planète et la signification de la vie de tous nos ancêtres qui ont contribué à l’avenir de leurs descendants. L’extinction est la fin de l’entreprise humaine.

Aujourd’hui, on est heureux que l’humanité n’ait pas disparu lors des précédentes ères glaciaires sinon la civilisation moderne n’aurait jamais pu exister. Nous pensons que nous avons une responsabilité similaire envers les personnes qui viendront après nous, en supposant (comme nous le pensons) qu’elles auront des vies qui valent la peine d’être vécues. Il serait imprudent et injuste de mettre leur existence en danger juste pour améliorer notre situation à court terme.

Ce n’est pas seulement que le futur pourrait contenir plus de monde que le présent. Comme l’a également souligné Sagan, tout ce qui a de la valeur pour vous a une chance d’exister en bien plus grande quantité dans le futur. Une future civilisation pourrait créer un monde où personne ne manque de rien, accomplir des prodiges scientifiques et donner naissance à des créations artistiques époustouflantes. Nous pourrions construire une société bien plus juste et vertueuse. Et il n’y a rien dans les théories scientifiques actuelles qui empêche notre civilisation d’atteindre d’autres planètes — au nombre de 100 milliards dans notre galaxie9. Si on laisse notre civilisation s’éteindre, alors rien de tout cela ne pourra jamais se produire.

Nous ne sommes pas sûrs que cet avenir radieux se produira réellement, mais c’est une raison de plus de faire en sorte que notre civilisation continue : avoir une chance de le découvrir. Ne pas transmettre le flambeau à la génération suivante pourrait bien être la pire chose possible.

Ainsi, une probabilité de 2 % que la civilisation prenne fin semble être le problème le plus urgent auquel le monde est confronté aujourd’hui. Ce qui est tout aussi frappant, c’est le peu d’attention accordée à ces risques.

Voici les sommes versées chaque année à certaines causes importantess :

| Cause | Dépenses annuelles ciblées (très approximativement) |

|---|---|

| R&D mondiale | 1 500 milliards de dollars |

| Produits de luxe | 1 300 milliards de dollars |

| Protection sociale aux États-Unis | 900 milliards de dollars |

| Changement climatique | >300 milliards de dollars |

| Pauvreté mondiale | >250 milliards de dollars |

| Sécurité nucléaire | 1 à 10 milliards de dollars |

| Prévention des pandémies graves | 1 milliard de dollars |

| Recherche sur la sûreté de l’IA | 10 millions de dollars |

Comme vous pouvez le constater, nous consacrons une grande quantité de ressources à la recherche et au développement afin de mettre au point des technologies encore plus puissantes. Nous dépensons également beaucoup pour tenter d’améliorer nos vies (à tort ou à raison) en achetant des produits de luxe.

On constate des dépenses bien inférieures lorsqu’il s’agit d’atténuer les risques de catastrophe planétaire liés au changement climatique. A titre de comparaison, les dépenses pour la protection sociale aux Etats-Unis, à elles seules, dépassent de loin les dépenses mondiales consacrées à la lutte contre le changement climatique.

Cependant, si on les compare à certains des autres risques que nous avons évoqués, même les sommes allouées au changement climatique paraissent énormes. Nous estimons que la prévention des pandémies extrêmes reçoit environ 300 fois moins d’argent, alors que le risque semble être à peu près de même taille.

La recherche visant à éviter les accidents causés par les systèmes d’IA est la plus négligée de toutes. Elle reçoit environ 100 fois moins de ressources, avec seulement environ 10 millions de dollars par an.

Le tableau serait similaire si l’on considérait le nombre de personnes travaillant sur ces risques plutôt que l’argent dépensé, mais il est plus facile d’obtenir des chiffres en termes de dépenses.

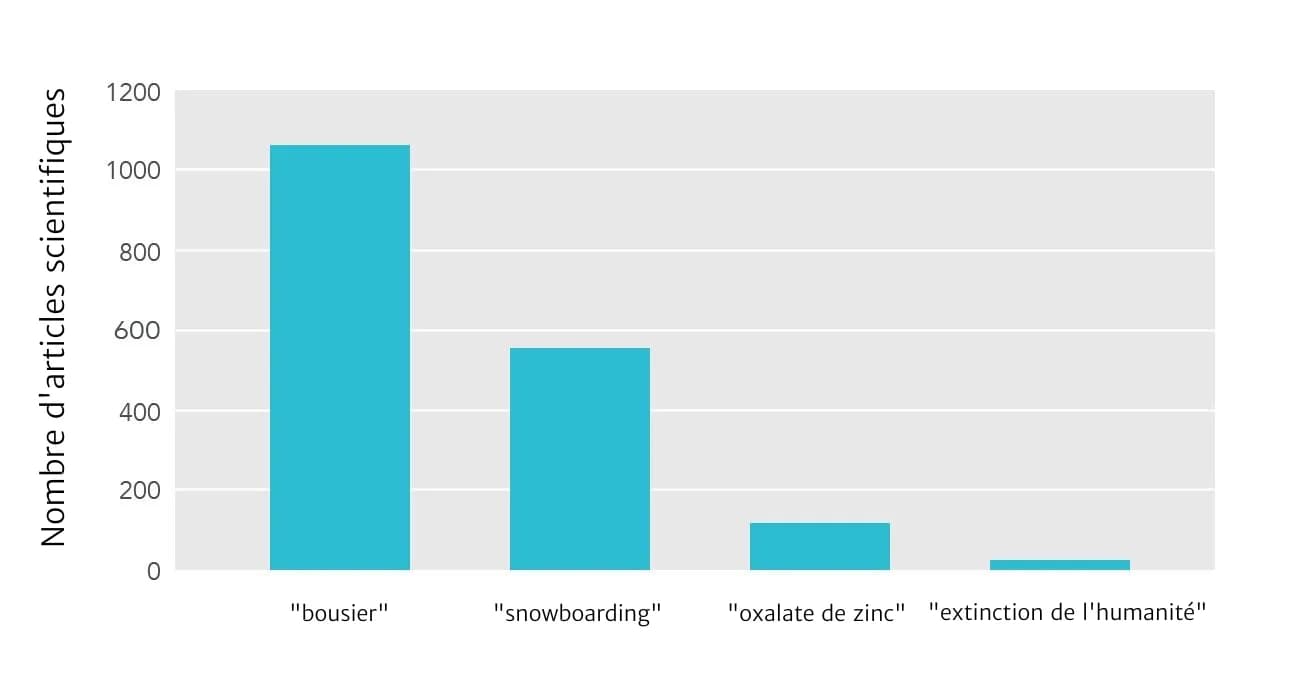

Si on examine plutôt le degré d’attention scientifique, on voit la même histoire d’une discipline négligée (bien que certains risques individuels reçoivent une attention significative, comme le changement climatique) :

Notre impression est que si l’on se penche sur l’attention politique portée à ces sujets, on obtient là aussi une image similaire. Une part écrasante de l’attention politique est consacrée aux questions concrètes qui aident la génération actuelle à court terme, puisque c’est ce qui récolte des voix lors des élections. Les risques de catastrophe planétaire sont beaucoup plus négligés. Parmi ces derniers, c’est le changement climatique qui retient le plus l’attention, tandis que des questions comme les pandémies et l’IA sont les plus négligées.

Ce manque de ressources, de recherche scientifique et d’attention politique, c’est exactement ce à quoi on s’attend quand on considère les motivations de chaque acteur pris individuellement : les politiciens veulent être élus à la prochaine élection, les chercheurs veulent être financés — ce qui requiert souvent de travailler sur des sujets en vogue… C’est pourquoi le domaine des risques catastrophiques planétaires offre une opportunité aux personnes qui veulent rendre le monde meilleur.

Tout d’abord, ces risques ne sont pas de la responsabilité d’une seule nation. Supposons que les États-Unis investissent massivement pour prévenir le changement climatique. Cela profiterait à tous les habitants de la planète, mais seuls 5 % environ de la population mondiale vit aux États-Unis, de sorte que les citoyens américains ne recevraient que 5 % des bénéfices de ces dépenses. Cela signifie que les États-Unis vont investir bien moins dans ces efforts par rapport à ce qu’ils pourraient rapporter au monde entier. Et il en va de même pour tous les autres pays.

Ce problème pourrait être résolu si nous pouvions tous nous coordonner — si chaque nation acceptait de contribuer une juste part à la réduction du changement climatique, toutes les nations en bénéficieraient en évitant ses pires effets.

Malheureusement, chaque pays considère que la situation la plus avantageuse est de laisser sa propre économie tranquille, pendant que tous les autres pays réduisent leurs émissions. Par conséquent, chaque nation est incitée à se retirer des accords sur le climat, ce qui explique le peu de progrès réalisés (c’est ce qu’on appelle le dilemme du prisonnier).

En fait, même cette constatation sous-estime grandement le problème. Ce sont les générations futures qui bénéficieront le plus des efforts visant à réduire les risques de catastrophe planétaire. Or elles n’ont aucun moyen de défendre leurs intérêts, que ce soit sur le plan économique ou politique.

Si les générations futures pouvaient voter lors de nos élections, elles voteraient massivement en faveur de politiques plus sûres. De même, si les générations futures pouvaient envoyer de l’argent dans le passé, elles seraient prêtes à nous payer d’énormes sommes pour réduire ces risques. (Techniquement, la réduction de ces risques crée un bien public transgénérationnel et mondial, ce qui en fait l’un des moyens les plus négligés de faire le bien.)

Notre système actuel ne permet pas de protéger les générations futures de manière adéquate. Nous avons fait la connaissance de hauts fonctionnaires du gouvernement britannique qui veulent faire quelque chose contre ces risques, mais ils disent tous unanimement que la pression des actualités et du cycle électoral fait qu’il est difficile de s’y consacrer. Dans la plupart des pays, aucune agence gouvernementale n’est consacrée à un sujet qui lui permettrait de se préoccuper de tels risques.

C’est une triste constatation, mais c’est aussi une opportunité. Pour les personnes qui veulent rendre le monde meilleur, ce manque d’attention signifie qu’il existe de nombreux moyens à fort impact pour aider.

Nous avons abordé l’ampleur et le délaissement de ces enjeux, mais qu’en est-il du troisième élément de notre approche, la solubilité ?

Dans des domaines plus conventionnels comme la santé mondiale, nous sommes davantage certains de pouvoir faire des progrès. Il est beaucoup plus facile de mesurer notre impact sur la santé (du moins à court terme) et nous disposons de décennies de preuves de ce qui fonctionne. En d’autres termes, travailler à la réduction des risques de catastrophe planétaire semble moins prometteur en termes de solubilité.

Cependant, il y a encore beaucoup à faire, et vu l’ampleur et le délaissement de ces risques, ce sont des questions urgentes.

Nous présentons quelques stratégies pour atténuer ces risques. Elles sont divisées en trois grandes catégories :

L’une des approches consiste à s’attaquer directement à chaque risque. Il y a de nombreuses propositions concrètes pour traiter chacun d’entre eux, par exemple :

Nous examinons dans le détail ce que vous pouvez faire pour vous attaquer à chacun de ces risques dans nos profils :

Dans cette section, nous ne mettons pas l’accent sur les risques d’origine naturelle car ils sont beaucoup moins probables et nous faisons déjà beaucoup pour prévenir certains d’entre eux. Nous sommes également plus résistants aux risques naturels grâce à l’avancée de la technologie et l’accroissement de la prospérité — qui sont déjà l’objet d’intenses efforts.

Plutôt que d’essayer de réduire chaque risque individuellement, nous pouvons essayer de faire en sorte que la civilisation soit généralement plus apte à les gérer. Des efforts « élargis » permettent de réduire toutes les menaces à la fois, même celles auxquelles nous n’avons pas encore pensé.

Par exemple, souvent au sein des gouvernements, il existe des décideurs clés qui géreront ces risques au fur et à mesure qu’ils adviennent. Si nous pouvions améliorer la capacité de décision de ces personnes et de leurs institutions, cela contribuerait à rendre la société en général plus résiliente et à résoudre de nombreux autres problèmes.

Des recherches récentes ont mis en évidence de nombreux moyens d’améliorer la prise de décision, mais la plupart n’ont pas encore été mis en œuvre. Peu de personnes travaillent sur cette question. Notre article sur l’amélioration de la prise de décision institutionnelle explore ce sujet plus en profondeur.

Un autre exemple d’effort élargi est de faire en sorte que notre civilisation puisse rebondir plus facilement après une catastrophe. La Réserve Mondiale de Semences est une chambre forte réfrigérée située dans l’Arctique qui contient les graines de nombreuses variétés de cultures importantes, réduisant ainsi le risque de perdre une espèce essentielle. Ce projet bénéficierait de financements supplémentaires, ne serait-ce que pour sa maintenance : suite à un dégel dû, ironiquement, au changement climatique, de l’eau s’est infiltré dans le tunnel menant à la chambre forte. Il y a beaucoup d’autres initiatives comme celle-ci que nous pourrions mettre en œuvre pour préserver nos connaissances et nos ressources.

Nous pourrions également créer de meilleurs abris d’urgence en cas de catastrophes, ce qui réduirait les risques d’extinction dus aux pandémies, à l’hiver nucléaire et aux astéroïdes (mais pas aux IA dangereuses), tout en augmentant nos chances de rétablissement après une catastrophe. Pour l’instant, ces mesures ne semblent pas aussi efficaces que réduire les risques en premier lieu, mais elles seraient tout de même utiles. Une option plus négligée, et peut-être beaucoup moins coûteuse, consiste à créer des sources de nourriture alternatives, comme celles qui peuvent être produites sans lumière, et qui pourraient être rapidement intensifiées en cas d’hiver prolongé.

Étant donné que les efforts élargis sont utiles même si nous ne sommes pas certains du détail des risques, ils sont d’autant plus intéressants que l’incertitude est grande. Au fur et à mesure que vous vous rapprochez des risques, vous devriez progressivement réaffecter les ressources depuis les efforts élargis vers les efforts ciblés (en savoir plus).

Nous nous attendons à ce qu’il existe de nombreuses autres interventions élargies prometteuses, mais c’est un domaine dans lequel peu de recherches ont été menées. Par exemple, une approche pourrait consister à améliorer la coordination internationale. Puisque ces risques sont causés par l’humanité, ils peuvent être prévenus par l’humanité, mais ce qui nous arrête, c’est la difficulté à coopérer. Par exemple, la Russie ne veut pas se désarmer parce que ça la désavantagerait par rapport aux États-Unis, et vice versa, même si les deux pays seraient dans une meilleure situation s’il n’y avait pas de possibilité de guerre nucléaire.

Cependant, il est peut-être possible d’améliorer notre capacité à nous coordonner en tant que civilisation, par exemple en améliorant les relations internationales ou en développant de meilleures institutions internationales. Nous souhaitons vivement que des recherches plus approfondies soient menées sur ce type de propositions.

Les efforts les plus connus pour faire le bien, comme le soutien à l’éducation et au développement international, peuvent également contribuer à rendre la société plus résiliente et plus sage, et donc à réduire les risques de catastrophe. Par exemple, une population mieux éduquée élirait probablement des dirigeants plus éclairés (quoique…), et les pays plus riches sont, toutes choses égales par ailleurs, mieux à même de prévenir les pandémies — ce n’est pas un hasard si Ébola s’est installé dans certaines des régions les plus pauvres d’Afrique de l’Ouest.

Mais nous ne considérons pas l’éducation et la santé comme les meilleurs domaines à privilégier pour maximiser son impact, et ce pour deux raisons. Premièrement, ces domaines sont bien moins délaissés que les approches non conventionnelles que nous avons abordées. Le développement de l’éducation est peut-être la cause la plus populaire pour les personnes qui veulent faire le bien, et rien qu’aux États-Unis, elle reçoit 800 milliards de dollars de financement public et 1000 milliards de financement privé. Deuxièmement, ces approches ont des effets beaucoup plus diffus sur la réduction des risques de catastrophe planétaire — il faudrait améliorer l’éducation à très grande échelle pour voir un effet notable. Nous préconisons donc de se concentrer sur des solutions plus ciblées et plus négligées.

Nous admettons être très incertains quant aux risques les plus importants, à la meilleure façon d’y faire face et à la possibilité que notre vision globale des priorités mondiales soit totalement erronée. Selon nous, cela signifie qu’un autre objectif clé est d’en savoir plus sur toutes ces problématiques.

Nous pouvons en apprendre davantage en essayant tout bonnement de réduire ces risques et en voyant quels progrès on arrive à réaliser. Nous pensons que le moyen le plus adapté d’en savoir plus à l’heure actuelle est de mener des recherches sur les priorités mondiales.

Il s’agit d’une approche combinant économie et philosophie morale qui vise à répondre à des questions de haut niveau sur les problèmes les plus importants pour l’humanité. Seule une poignée de chercheurs travaille à plein temps sur ces sujets.

Une autre façon de gérer l’incertitude consiste à accumuler des ressources qui pourront être déployées à l’avenir, lorsque l’on disposera de plus d’informations. Une façon d’y parvenir est de gagner et d’épargner de l’argent. Vous pouvez également investir dans votre capital professionnel, en particulier dans vos compétences transférables et vos réseaux d’influence, afin d’obtenir de meilleurs résultats à long terme.

Cependant, nous pensons qu’une approche potentiellement meilleure que l’une ou l’autre de ces options consiste à construire une communauté qui serait concentrée exclusivement sur la réduction de ces risques, quels qu’ils soient. Si cette approche est intéressante, c’est parce qu’il est possible d’accroître la capacité d’une communauté plus rapidement que vous ne pouvez accroître votre richesse individuelle ou votre capital professionnel. Par exemple, si vous passez un an à faire de la sensibilisation individuelle ciblée, il n’est pas exclu de trouver une personne ayant une expertise pertinente qui sera sensible à vos arguments. Cela équivaut à un bénéfice annuel de 100 % puisque vous passez d’une personne à deux.

Pour l’instant, nous nous attachons à développer la communauté de l’altruisme efficace, qui compte de nombreuses personnes désireuses de réduire ces risques existentiels. Son taux de croissance récent et le déploiement d’efforts spécifiques pour développer la communauté suggèrent que des retombées élevées sont possibles.

Toutefois, nous pensons que d’autres efforts de renforcement de la communauté seront également utiles. Il serait formidable de voir une communauté de scientifiques essayer de promouvoir une culture de la sécurité dans le monde universitaire. Il serait tout aussi formidable de voir une communauté de décideurs politiques qui veulent essayer de réduire ces risques, et faire en sorte que les gouvernements se préoccupent davantage des générations futures.

Étant donné le peu de personnes qui travaillent activement à la réduction de ces risques, nous pensons qu’il y a beaucoup à faire pour créer un véritable mouvement.

Si l’on considère toutes les approches visant à réduire ces risques, et le peu de ressources consacrées à certaines d’entre elles, il semble que des progrès substantiels soient possibles.

Même si on ne considère l’impact de ces risques que sur la génération actuelle (en ignorant tout bénéfice pour les générations futures), il est plausible qu’ils restent une priorité absolue.

Voici quelques chiffres très approximatifs et simplifiés, juste pour illustrer en quoi c’est possible. 100 milliards d’euros consacrés à la réduction d’une menace existentielle pourraient la réduire de plus de 1 % au cours du siècle prochain. Une réduction d’un pourcent du risque devrait permettre de sauver environ 100 millions de vies parmi notre génération (1 % de la population mondiale actuelle). Cela signifie que cet investissement permettrait de sauver des vies pour seulement 1 000 euros par personnet.

Gregory Lewis a fait une estimation plus détaillée, arrivant à une moyenne de 9 200 euros par année de vie sauvée dans la génération actuelle (ou ~300 000 euros par vie)u. Il y a également d’autres estimations parmi les commentaires de l’article. Nous pensons que Gregory est trop conservateur car il suppose que le risque d’extinction n’est que de 1 % au cours du prochain siècle ; notre estimation est plusieurs fois supérieure. Nous pensons également que le prochain milliard d’euros dépensé pour réduire le risque existentiel pourrait entraîner une réduction plus importante du risque que ne le suppose Gregory (notez que cela n’est vrai que si le milliard est dépensé sur les questions les plus délaissées comme la sécurité de l’IA et les biorisques). Par conséquent, il ne serait pas surprenant que le coût par vie actuelle sauvée pour le prochain milliard d’euros investi dans l’atténuation du risque existentiel soit inférieur à 100 euros.

L’organisation caritative la plus recommandée par GiveWell, Against Malaria Foundation (AMF — Fondation pour la lutte contre le paludisme), est souvent présentée comme l’un des meilleurs moyens d’aider la génération actuelle et de sauver des vies, avec un coût d’environ 7 500 dollars par vie sauvée (chiffres de 2017)v. Ces estimations placent donc la réduction de la menace existentielle à un niveau de rentabilité supérieur ou égal à celui de l’AMF pour sauver des vies dans la génération actuelle — et c’est une organisation qui a été spécifiquement sélectionnée pour son excellence dans ce domaine !

De même, nous pensons que si 10 000 jeunes gens talentueux concentrent leur carrière sur ces risques, ils pourraient obtenir une réduction de 1 % des risques. Cela signifie que chaque personne sauverait 1 000 vies au cours de sa propre vie, ce qui est supérieur au nombre de vies qu’elle pourrait sauver en gagnant pour donner et en faisant un don à l’Against Malaria Foundationw.

Dans un sens, il s’agit de comparaisons injustes, car l’estimation de GiveWell est beaucoup plus solide et documentée alors que notre estimation est davantage une supposition éclairée. Il existe peut-être aussi de meilleures façons d’aider la génération actuelle que l’AMF (par exemple en soutenant des politiques plus efficaces).

Cependant, nous admettons avoir également sous-estimé de façon spectaculaire les avantages de la réduction des menaces existentielles. La principale raison de sauvegarder notre civilisation n’est pas de profiter à la génération actuelle mais aux générations futures. Nous les avons ignorées dans cette estimation.

Si nous prenons également en compte les générations futures, le bénéfice de la réduction des menaces existentielles est bien plus grand, et il est difficile d’imaginer une priorité plus urgente à l’heure actuelle.

Vous pouvez maintenant lire quelques réponses à des questions courantes, ou passer directement aux moyens concrets de contribuer.

Les arguments présentés reposent sur certaines hypothèses que tout le monde n’acceptera pas. Voici quelques-unes des meilleures réponses à ces arguments.

Nous pensons que nos propositions devraient être une priorité seulement si on essaye d’aider les gens en général, en traitant les intérêts de chacun de manière égale (ce que les philosophes appellent parfois « altruisme impartial »).

La plupart des gens se soucient d’aider les autres du mieux qu’ils peuvent : si on peut aider un inconnu à peu de frais, c’est une bonne chose à faire. Les gens ont également à cœur de bien vivre leur propre vie et de s’occuper de leurs amis et de leur famille, et il en va de même pour nous.

Comment équilibrer ces priorités est une question difficile. Si vous avez la chance de pouvoir contribuer à aider le monde, concentrez-vous sur la sauvegarde de l’avenir. Nous énumérons dans la section suivante des moyens concrets de s’impliquer.

Sinon, vous devriez peut-être vous concentrer sur votre vie personnelle dès maintenant, en contribuant à des causes plus vastes en parallèle, ou plus tard dans votre vie.

Nous ne disposons pas d’estimations solides de la plupart des risques d’origine humaine. Vous pourriez donc essayer de faire vos propres estimations et conclure qu’elles sont beaucoup plus faibles que celles que nous avons présentées dans l’article. Si ces risques étaient suffisamment faibles, leur réduction cesserait d’être la priorité absolue.

Nous ne trouvons pas cela plausible pour les raisons évoquées dans l’article : si on prend en compte tous les risques potentiels, il semble difficile d’être sûr qu’ils sont inférieurs à 1 % au cours du siècle qui vient, et même un risque de 1 % justifie une mobilisation bien supérieure à ce que nous observons actuellement.

Nous considérons que ces risques sont moins « solubles » que des problèmes comme la santé mondiale, et s’attend donc à ce que le progrès obtenu par euro investi soit plus laborieux. Cela dit, nous pensons que leur ampleur et le fait qu’ils soient négligés compensent largement cet état de fait, et les efforts fournis finissent par être plus efficaces. De nombreuses personnes pensent que l’altruisme efficace consiste à ne soutenir que des interventions « éprouvées », mais c’est un mythe. Il vaut la peine de prendre des mesures qui n’ont qu’une faible chance de porter leurs fruits, si les bénéfices possibles sont suffisamment élevés. Le principal mécène de l’altruisme efficace préconise désormais une approche de « dons-paris » où même si la majorité des dons produisent peu de résultats, quelques dons sont extraordinairement efficaces.

Toutefois, si vous êtes beaucoup plus pessimiste quant aux chances de progrès, il serait peut-être préférable de travailler sur des questions plus conventionnelles telle que la santé mondiale.

Notre opinion est que l’organisation tournerait son attention vers un autre sujet si elle observait une augmentation des ressources consacrées à ces risques de deux ordres de grandeur, soit environ cent fois plus. Mais on en est encore loin.

Un autre argument courant est que les mesures que nous avons déjà adoptées sont les meilleures pour réduire ces risques. Cela signifie qu’en pratique, nous n’avons aucune raison de changer nos priorités. Par exemple, nous avons mentionné précédemment que l’éducation contribue probablement à réduire les risques existentiels. Si vous estimez que l’éducation est la meilleure réponse (peut-être parce que vous ne voyez pas clairement quels sont les risques les plus urgents, et vous favorisez donc une mesure générale qui peut aider pour beaucoup de risques), et comme nous investissons déjà énormément dans l’éducation, vous pourriez penser que la situation est déjà gérée. Nous ne trouvons pas cet argument crédible : comme indiqué ci-dessus, il existe de nombreuses opportunités de réduction des risques qui sont ciblées, négligées, et qui restent inexploitées.

Un autre exemple de ce type: des économistes prétendent parfois que nous devrions nous concentrer sur la croissance économique, car cela nous mettrait dans la meilleure position possible pour gérer les risques à l’avenir. Nous ne sommes pas convaincus par cet argument car certains types de croissance économique augmentent les risques existentiels (par exemple, la découverte de nouvelles armes). Il n’est donc pas certain que la croissance économique soit un moyen idéal de réduire les risques existentiels. Au lieu de cela, ils préconisent de se concentrer au moins sur le développement technologique différentiel, ou sur les autres efforts plus ciblés énumérés ci-dessus.

Bien que la réduction de ces risques vaille la peine pour notre génération actuelle, une grande partie de leur importance vient de leurs effets à long terme — car si la civilisation s’éteint, nous renonçons à tout avenir.

Vous pensez peut-être qu’il existe d’autres actions que la génération actuelle pourrait entreprendre et qui auraient des effets à très long terme ; des actions qui pourraient être tout aussi importantes pour réduire le risque d’extinction. En particulier, nous pourrions être en mesure d’améliorer la qualité de notre avenir en empêchant notre civilisation de s’enfermer définitivement dans de mauvais scénarios.

Nous donnons quelques exemples certes farfelus mais inquiétants. Une possibilité est que les nouvelles technologies, comme la surveillance extrême ou le conditionnement psychologique, permettent de créer un gouvernement totalitaire auquel on ne pourrait jamais mettre fin. Ce serait le scénario de Nineteen Eighty-Four en cas de surveillance extrême, et celui de Brave New World en cas de conditionnement psychologique. Si ce gouvernement était malveillant, la civilisation pourrait connaître un sort pire que l’extinction, une souffrance qui durerait des millénaires.

Certains s’inquiètent du fait que le développement de systèmes d’IA avancés pourrait causer des dommages terribles si ces projets complexes sont effectués de manière irresponsable, peut-être parce qu’il existerait un conflit entre plusieurs groupes développant cette technologie. En particulier, si à un moment donné dans le futur, le développement de ces systèmes implique la création d’esprits numériques capables de ressentir la douleur, leur bien-être pourrait devenir incroyablement important.

Les risques d’un avenir contenant une quantité astronomique de souffrances ont été appelés « s-risques »x. Si nous pouvons faire quelque chose aujourd’hui pour empêcher un s-risque de se produire (par exemple, par une recherche ciblée sur la sécurité technique de l’IA et la gouvernance de l’IA), cela pourrait être d’un grand bénéfice. Un autre domaine à examiner est celui des grandes transitions technologiques. Nous avons mentionné les dangers du génie génétique et de l’intelligence artificielle dans cet article, mais ces technologies pourraient également créer une deuxième révolution industrielle et avoir un fort impact positif sur le monde une fois déployées. Il y a peut-être des choses que nous pouvons faire pour augmenter la probabilité d’une bonne transition, plutôt que de diminuer le risque d’une mauvaise transition. Cette perspective a été décrite comme une tentative d’augmenter l’« espoir existentiel » plutôt que de diminuer le « risque existentiel »11.

Il pourrait y avoir d’autres moyens d’avoir des effets à très long terme, et ils pourraient être plus urgents que la réduction du risque d’extinction. Cependant, la plupart de ces propositions ne sont pas encore aussi détaillées, et nous ne sommes pas sûrs de ce qu’il faut faire à leur sujet.

Selon nous, la principale implication pratique de cette réflexion sur les autres moyens d’influencer l’avenir est qu’elle nous a convaincus encore davantage de l’importance de gérer positivement la transition vers de nouvelles technologies transformatrices, telles que l’IA. Elle nous a aussi donné envie de voir plus de recherches émerger autour de ces questions. Dans l’ensemble, nous pensons toujours qu’il est judicieux de se concentrer d’abord sur la réduction des menaces existentielles. Nous pourrons nous intéresser à d’autres moyens pour préparer notre futur commun dans un second temps.

Un moyen d’améliorer l’avenir dont nous sommes tout sauf convaincus est de l’accélérer. Certaines personnes qui veulent améliorer l’avenir se concentrent sur les progrès technologiques, comme la mise au point de nouveaux vaccins, et il est vrai que cela a des avantages sur le long terme. Toutefois, nous pensons que ce qui compte le plus, dans une perspective à long terme, c’est le résultat final plutôt que la vitesse à laquelle nous y parvenons. La découverte d’un nouveau vaccin signifie que nous obtenons le vaccin plus tôt dans notre histoire ; il est très probable que nous l’aurions découvert de toute façon.

En outre, comme la technologie est également à l’origine de bon nombre de ces risques, il n’est pas certain que son accélération soit utile à court terme. L’accélération du progrès est également une thématique beaucoup moins négligée, car elle profite aussi à la génération actuelle. Comme nous l’avons évoqué, plus de 1 000 milliards de dollars sont dépensés chaque année en R&D pour développer de nouvelles technologies. Les accélérations sont donc à la fois moins importantes et moins négligées.

Pour en savoir plus sur les autres moyens d’aider les générations futures, consultez le chapitre 3 de l’ouvrage On the Overwhelming Importance of Shaping the Far Future (L’importance primordiale de façonner l’avenir lointain, non traduit) de Nick Beckstead.

Si vous pensez qu’il est pratiquement garanti que la civilisation ne durera pas longtemps, alors l’intérêt de réduire ces risques existentiels est considérablement diminué (bien que cette action en vaille la peine pour aider la génération actuelle et un petit nombre de générations futures).

Nous nous accordons pour dire qu’il y a une forte probabilité que la civilisation se termine bientôt (c’est pourquoi cette question est si importante), mais ils pensent aussi qu’il y a une assez grande probabilité qu’elle dure très longtemps, ce qui fait que notre avenir vaut bien qu’on se batte pour lui.

De même, si vous pensez qu’il est probable que l’avenir sera plus négatif que positif (ou si vous pensez que nous devons avant tout diminuer la souffrance à travers le monde, plutôt que d’augmenter le bien-être), alors la valeur de la réduction de ces risques diminue. Cependant, nous ne pensons pas que ce soit probable : la plupart d’entre nous voulons que l’avenir soit prometteur, et tenterons de le rendre plus positif que négatif. Il y a eu des progrès moraux significatifs au cours des derniers siècles (en raison des tendances mentionnées plus haut), et nous restons optimistes quant à leur poursuite. Pour plus de détails, voir la note de bas de pagey.

Et même si vous n’êtes pas sûr que l’avenir va être positif, vous pouvez désirer que la civilisation survive et que nous ne nous fermions pas de portes. Les populations futures auront beaucoup plus de temps pour étudier s’il est souhaitable que la civilisation s’étende, reste de la même taille ou se contracte. Si vous pensez qu’il y a des chances que nous puissions agir en fonction de ces préoccupations morales, c’est une bonne raison de laisser cette décision à la sagesse des générations futures. Dans l’ensemble, nous avons encore beaucoup de doutes sur toutes ces questions, ce qui nous incite à éviter de prendre des engagements irréversiblesz.

Au-delà de cela, vous devriez probablement vous concentrer sur les moyens de réduire la probabilité que l’avenir soit sombre, en travaillant sur les moyens d’éviter les s-risques par exemple.

Si vous pensez que nous avons des obligations beaucoup plus fortes envers la génération actuelle qu’envers les générations futures, alors l’importance de réduire ces risques diminue. Nous ne trouvons pas ce point de vue très convaincant. Cela dit, même si l’on ignore les générations futures, ces risques semblent valoir la peine d’être abordés (voir les arguments ci-dessus). Les efforts suggérés dans l’article pourraient sauver la vie de la génération actuelle à un coût relativement faible, et ils pourraient éviter de nombreuses souffrances lors de catastrophes de taille moyenne.

De plus, si vous n’êtes pas sûrs que nous ayons des obligations morales envers les générations futures, vous devriez tenter de rester ouvert à toutes les possibilités. Ce qui signifie, finalement, essayer de sauvegarder la civilisation.

Néanmoins, si vous combinez l’opinion selon laquelle nous n’avons pas de grandes obligations envers les générations futures avec la position selon laquelle les risques mentionnés sont également relativement insolubles, alors une autre façon d’aider les générations actuelles pourrait prendre le dessus. Il pourrait s’agir de travailler sur la santé mondiale, la santé mentale ou l’accélération de la technologie. Vous pouvez aussi penser qu’une autre question morale est bien plus pressante, comme l’élevage industriel par exemple.

Notre génération peut soit contribuer à provoquer la fin de tout, soit être la génération qui fera traverser à l’humanité sa période la plus dangereuse, et devenir ainsi l’une des générations les plus importantes de l’Histoire.

Nous pouvons être la génération qui rendra possible l’avènement d’un monde extraordinaire et prospère, ou nous pouvons être la génération qui mettra tout en péril.

Si nous souhaitons aider le monde, c’est sur ce point que nous devons concentrer nos efforts.

Si vous souhaitez axer votre carrière sur la réduction des menaces existentielles et la sauvegarde de l’avenir de l’humanité, 80 000 Hours veut vous y aider. L’équipe a rédigé un article décrivant les options qui s’offrent à vous et les mesures que vous pouvez prendre pour commencer.

Vous pouvez également contacter l’équipe d’Altruisme Efficace France pour bénéficier d’un entretien carrière.

Cet article fait partie de notre série avancée. Consultez la série complète ou poursuivez votre lecture :